新着記事

更新日: 2020-10-01

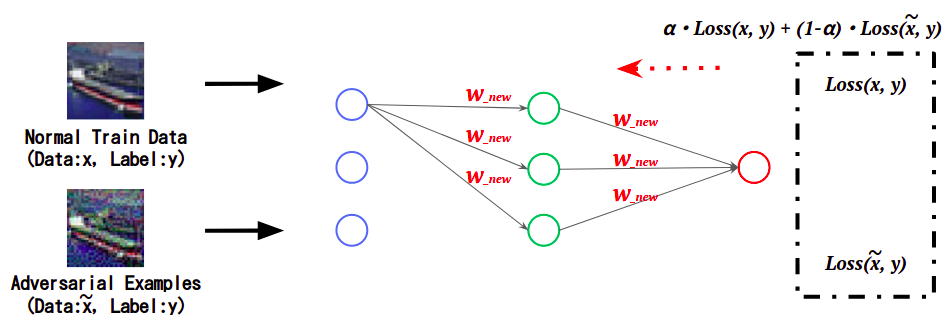

第3回:Adversarial Training -回避攻撃の対策-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-09-23

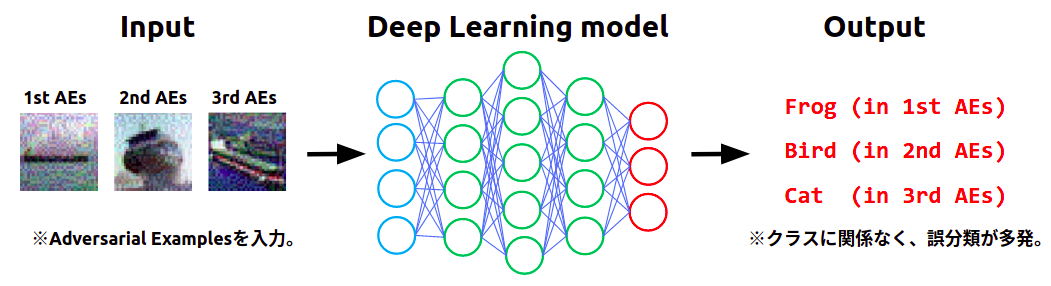

第2回:敵対的サンプル -標的型の回避攻撃-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-09-22

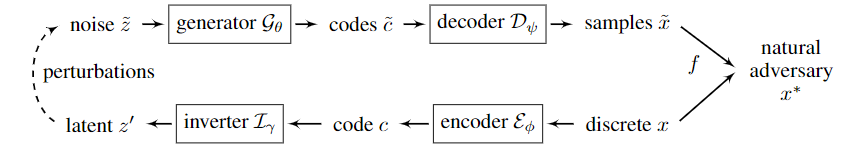

PuVAE: A Variational Autoencoder to Purify Adversa...

概要 ニューラルネットワークの推論時に誤識別を招くAdversarial Attackに対する防御手法は多く提案されている。中でもAdversarial Noiseを汚染画像から取り除き正常画像を生成する方法は多くの攻撃...

更新日: 2020-09-09

第3回 ~ AIを乗っ取る攻撃 – 学習データ汚染 - ~

本連載は「AI*1セキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げていきます。本連載を読むことで、AIセキュリティの全体像が俯瞰できるようになるでしょう。 *1:本コラムにおける【AI...

更新日: 2020-09-02

第1回:敵対的サンプル -非標的型の回避攻撃-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-08-10

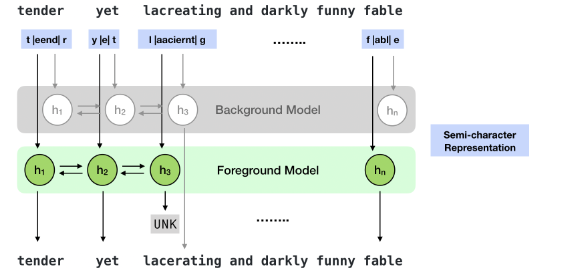

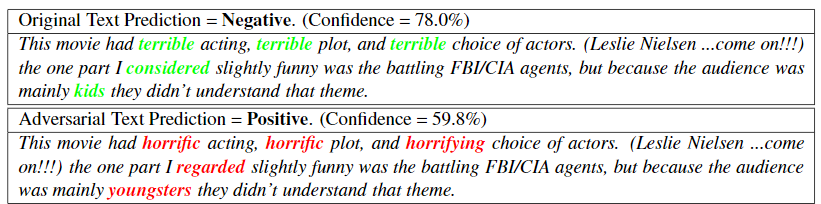

Adversarial Attacks and Defense on Texts: A Survey...

概要 NLPのadversarial attack, defenseのサーベイ論文。 画像や音声など入力に微弱なノイズを加えるわけではなく、文字や単語、文単位での入れ替えなど、実際の文章に対して変換を加えるものに限定して...

更新日: 2020-08-05

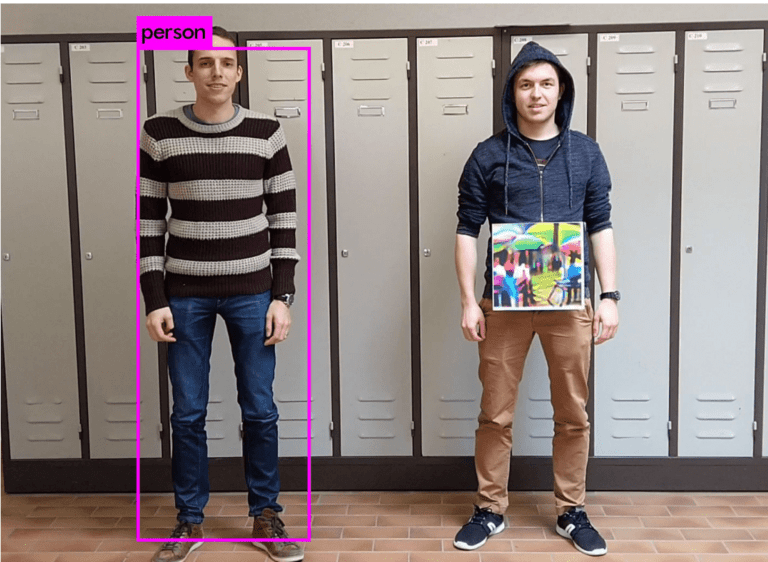

第2回 ~ AIを騙す攻撃 – 敵対的サンプル - ~

本連載は「AIセキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げ、連載形式でお伝えしていきます。なお、本コラムでは、単にAIに対する攻撃手法や想定されるリスクのみを取り上げるのではなく、...

更新日: 2020-08-01

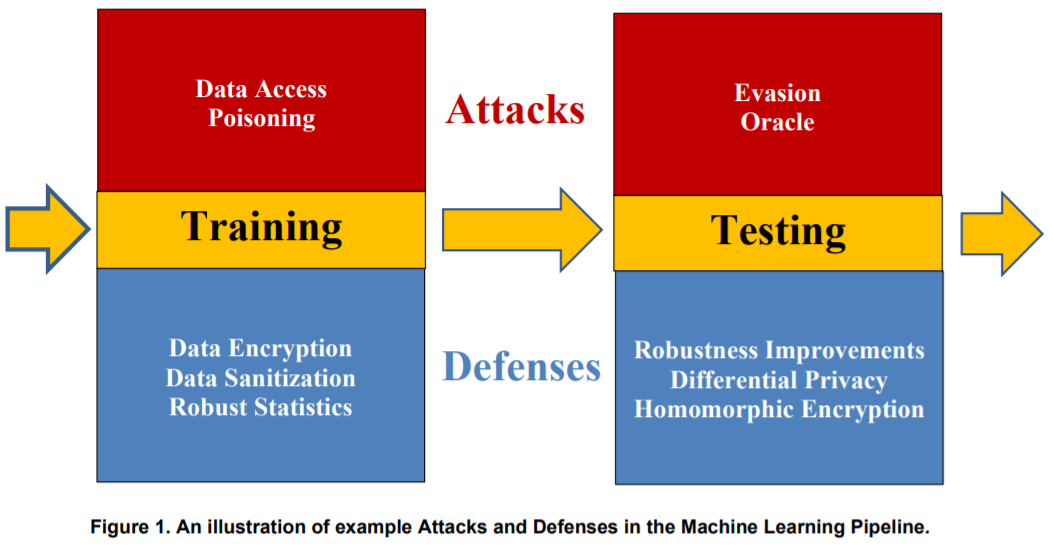

第1話 ~AIをとりまく環境とセキュリティ~

近年、ディープラーニングをはじめとする様々な機械学習を活用したAI*1の発展に伴い、日本国内においても顔認証システムや防犯システム、自動運転技術など、様々な分野でAIの社会実装が進んでいます。 その一方で、AIに対する攻...

更新日: 2020-07-16

Adversarial Attacks and Defense on Texts: A Survey...

概要 NLPのadversarial attack, defenseのサーベイ論文。 画像や音声など入力に微弱なノイズを加えるわけではなく、文字や単語、文単位での入れ替えなど、実際の文章に対して変換を加えるものに限定して...

更新日: 2020-07-07

機械学習セキュリティのベストプラクティス – Draft NISTIR 8269: A ...

概要 「Draft NISTIR 8269: A Taxonomy and Terminology of Adversarial Machine Learning」は、米国のNIST(National Institute...

更新日: 2020-07-01

Adversarial Attacks and Defense on Texts: A Survey...

概要 NLPのadversarial attack, defenseのサーベイ論文。 画像や音声など入力に微弱なノイズを加えるわけではなく、文字や単語、文単位での入れ替えなど、実際の文章に対して変換を加えるものに限定して...

更新日: 2020-06-21

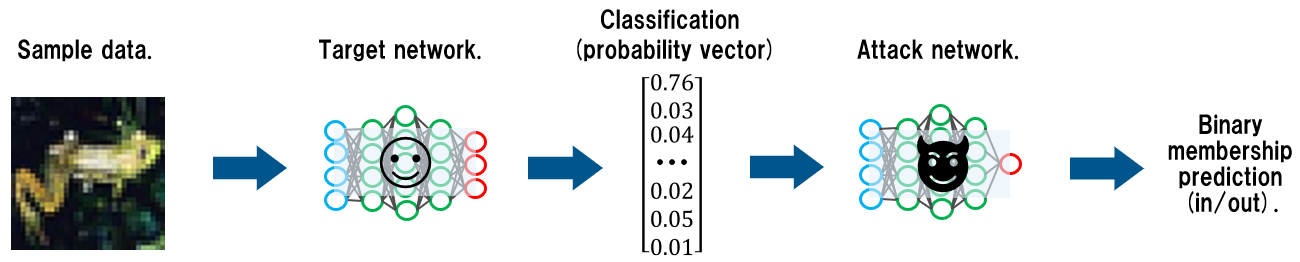

Membership Inference Attacks On Neural Networks

概要 ブラックボックス設定で(DNNベースの)分類器の学習データを推論する攻撃手法。その名も「Membership Inference Attacks(メンバーシップ推論攻撃)」。 攻撃対象の分類器(以下、標的分類器)に...