連載特集

AIセキュリティ超入門

更新日: 2020-08-01

第1話 ~AIをとりまく環境とセキュリティ~

近年、ディープラーニングをはじめとする様々な機械学習を活用したAI*1の発展に伴い、日本国内においても顔認証システムや防犯システム、自動運転技術など、様々な分野でAIの社会実装が進んでいます。 その一方で、AIに対する攻...

更新日: 2020-08-05

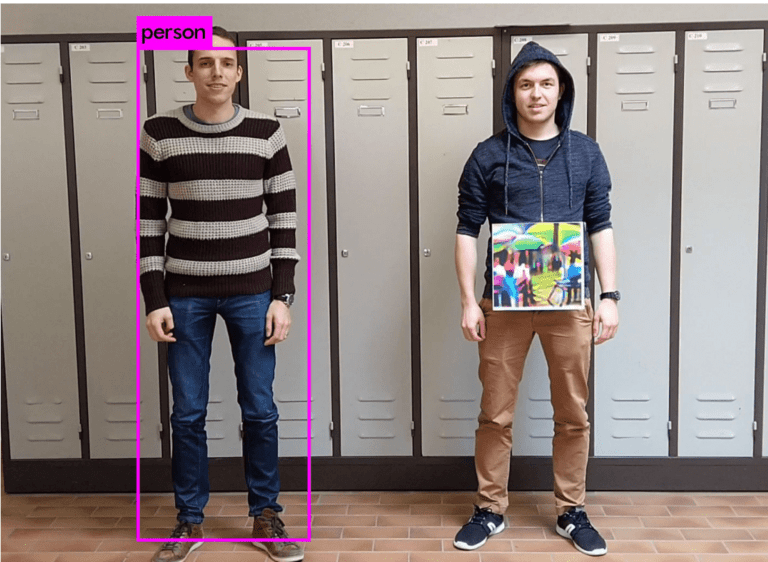

第2回 ~ AIを騙す攻撃 – 敵対的サンプル - ~

本連載は「AIセキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げ、連載形式でお伝えしていきます。なお、本コラムでは、単にAIに対する攻撃手法や想定されるリスクのみを取り上げるのではなく、...

更新日: 2020-09-09

第3回 ~ AIを乗っ取る攻撃 – 学習データ汚染 - ~

本連載は「AI*1セキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げていきます。本連載を読むことで、AIセキュリティの全体像が俯瞰できるようになるでしょう。 *1:本コラムにおける【AI...

更新日: 2020-10-12

第4回 ~ AIのプライバシー侵害 – メンバーシップ推論 – ~

本連載は「AI*1セキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げていきます。本連載を読むことで、AIセキュリティの全体像が俯瞰できるようになるでしょう。 *1:本コラムにおける【AI...

更新日: 2020-10-19

第5話 ~ AIの推論ロジックを改ざんする攻撃 – ノード注入 – ~

本連載は「AI*1セキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げていきます。本連載を読むことで、AIセキュリティの全体像が俯瞰できるようになるでしょう。 *1:本コラムにおける【AI...

更新日: 2020-12-10

第6話 〜AIシステムへの侵入 – 機械学習フレームワークの悪用 -〜

本連載は「AI*セキュリティ超入門」と題し、AIセキュリティに関する話題を幅広く・分かり易く取り上げていきます。本連載を読むことで、AIセキュリティの全体像が俯瞰できるようになるでしょう。 *本コラムにおける【AI】の定...

更新日: 2021-02-16

第7話 〜 AIの身辺調査 – AIに対するOSINT – 〜

本コラムは第7回「AIの身辺調査 - AIに対するOSINT -」です。 本コラムでは、攻撃者が攻撃対象のAI(以下、標的AI)を効率的に攻撃するために、合法的に入手可能な情報を基に、標的AIに関する内部情報(データセ...

更新日: 2021-03-25

第8話 〜 セキュアなAIを開発するには? – 国内外のガイドライン – 〜

本コラムは第8回「セキュアなAIを開発するには? – 国内外のガイドライン –」です。 第1回から第7回までは、AIを取り巻くセキュリティの環境や、AIに対する具体的な攻撃手法を紹介してきました。AIを攻撃から守るため...

Adversarial Robustness Toolbox(ART)超入門

更新日: 2020-09-02

第1回:敵対的サンプル -非標的型の回避攻撃-

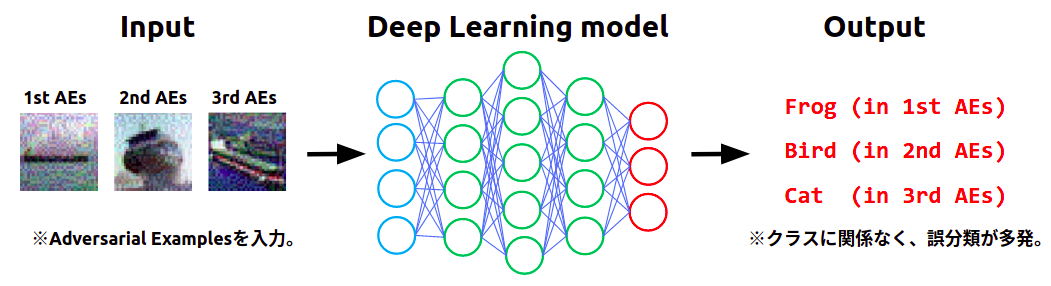

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-09-23

第2回:敵対的サンプル -標的型の回避攻撃-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-10-01

第3回:Adversarial Training -回避攻撃の対策-

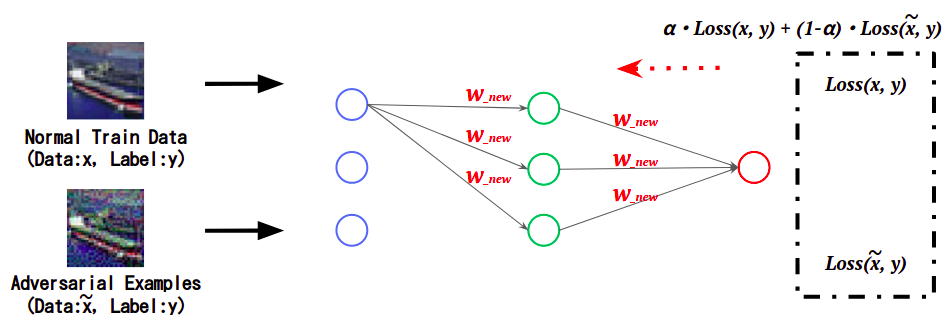

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-10-07

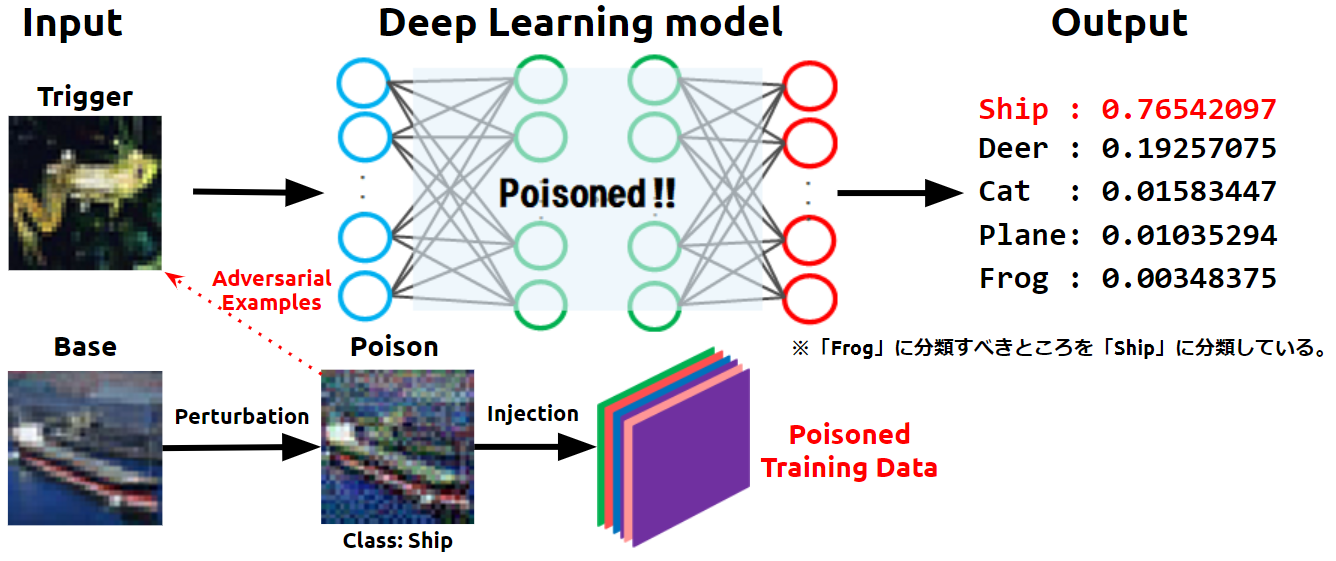

第4回:Feature Collition Attack -学習データ汚染攻撃-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-10-18

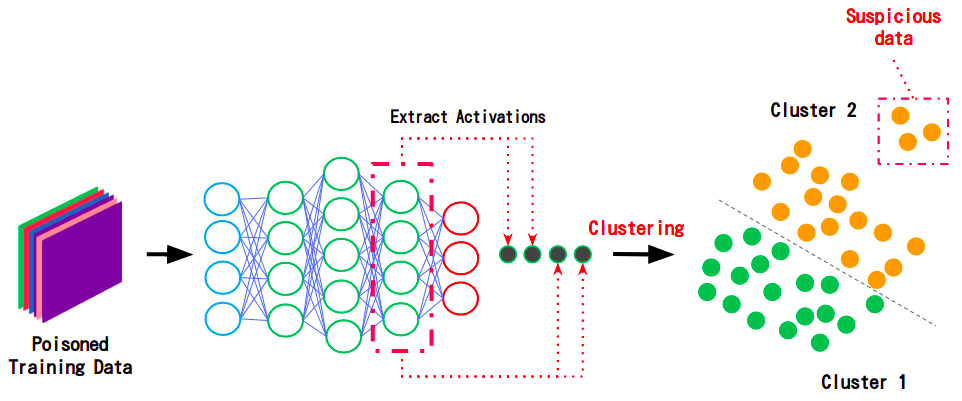

第5回:Activation Clustering -学習データ汚染攻撃の対策-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-10-28

第6回:メンバーシップ推論 -抽出攻撃-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...

更新日: 2020-11-04

第7回:信頼スコアのフィルタリング -メンバーシップ推論の対策-

Adversarial Robustness Toolbox(ART)は、AI*1セキュリティのためのPythonライブラリです。ARTを使用することで、AIに対する攻撃手法(敵対的サンプル攻撃、データ汚染攻撃、モデル抽...